Материалы по тегу: периферийные вычисления

|

02.06.2024 [15:30], Сергей Карасёв

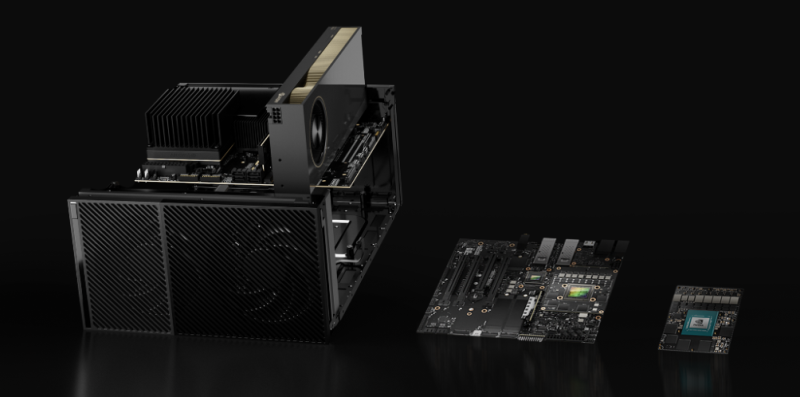

NVIDIA представила платформу AI Enterprise-IGX для индустриальных ИИ-приложенийКомпания NVIDIA сообщила о доступности комплексного решения AI Enterprise-IGX, которое, как утверждается, призвано удовлетворить растущую потребность в ИИ-вычислениях в реальном времени на периферии в таких областях, как медицина, промышленность и пр. Продукт объединяет NVIDIA IGX и систему Holoscan, а также Isaac и Metropolis. Напомним, IGX — это платформа индустриального уровня для ИИ-вычислений на периферии, специально разработанная для промышленных и медицинских сред. Holoscan предоставляет собой полнофункциональную инфраструктуру, необходимую для масштабируемой программно-определяемой обработки потоковых данных в режиме реального времени на периферии. Отмечается, что AI Enterprise-IGX предоставляет предприятиям новый уровень производительности, безопасности и поддержки для всего стека ПО для периферийных вычислений. В результате, упрощается и ускоряется развёртывание ИИ-приложений на периферии. Благодаря сочетанию NVIDIA AI Enterprise-IGX и Holoscan на базе IGX-платформ клиенты получают решение с гибкими возможностями интеграции сенсоров, высокой ИИ-производительностью и безопасностью для решения задач на периферии. Вместе с тем NVIDIA объявила об обновлении самой аппаратной платформы IGX. В частности, для IGX Orin 700 (кодовое имя IGX Boardkit) реализована поддержка ускорителей NVIDIA RTX 6000 Ada, что обеспечивает ИИ-производительность до 1,705 TOPS — это в семь раз больше по сравнению с показателем, который достигается при использовании интегрированного GPU. Кроме того, появилась поддержка «системы на модуле» IGX Orin 500. Говорится также, что программа сертификации NVIDIA-Certified Systems теперь распространяется на платформу IGX. Такие продукты готовят Advantech, Adlink, Aetina, Ahead, Cosmo Intelligent Medical Devices (подразделение Cosmo Pharmaceuticals), Dedicated Computing, Leadtek, Onyx, YUAN и др. Вместе с тем многие компании, работающие в области медицинских технологий, включая Barco, Karl Storz, Medtronic и Moon Surgical, внедряют NVIDIA IGX с системой Holoscan для ускорения разработки ИИ-решений для медицинской диагностики, хирургических роботов, средств по уходу за пациентами и пр.

27.05.2024 [09:09], Сергей Карасёв

Simply NUC представила мини-ПК extremeEDGE ServerКомпания Simply NUC анонсировала устройства семейства extremeEDGE Server, предназначенные для выполнения различных задач на периферии. Фактически это мини-серверы, которые в зависимости от модификации несут на борту процессор AMD или Intel и поддерживают различные средства проводного и беспроводного подключения к сети. Особенностью устройств является технология NANO-BMC. Модуль BMC, или Baseboard Management Controller, контролирует работу платформы и выполняет ряд важных функций, таких как управление питанием, мониторинг датчиков, возможность удалённого обновления прошивки, регистрация событий и пр. В случае extremeEDGE Server технология NANO-BMC помогает организовать вычисления на периферии. Новое семейство включает три серии: extremeEDGE 1000 для IoT-шлюзов и военных приложений, extremeEDGE 2000 для приложений ИИ и промышленной автоматизации, а также extremeEDGE 3000 для критически важных развёртываний в суровых условиях.

Источник изображения: Simply NUC Решения extremeEDGE 1000 комплектуются чипом Intel Celeron N5105 или Intel Processor N100; максимальный объём оперативной памяти составляет 32 Гбайт. Вместимость накопителя в зависимости от версии — 2 или 8 Тбайт. Присутствуют два порта 2.5GbE и дополнительный порт 1GbE BMC. Для некоторых вариантов в качестве опций доступны контроллер Wi-Fi и модем 4G. Имеются интерфейсы HDMI, USB 3.2 Type-A и USB Type-C 2.0. Устройства extremeEDGE 2000, в свою очередь, несут на борту процессор AMD V3C18I, Ryzen 7 7840U или Ryzen 7 Pro 8840U. Максимальный объём оперативной памяти — 96 Гбайт. Есть возможность установки двух SSD формата М.2 2280; ёмкость подсистемы хранения данных — до 16 Тбайт. Присутствуют два порта 2.5GbE и порт 1GbE BMC. Старшие модификации также наделены двумя разъёмами 10GbE SFP+. В качестве опций предлагаются поддержка PoE+ и установка дополнительного ИИ-ускорителя. Решения серии extremeEDGE 3000 предлагают такой же выбор процессоров, что и extremeEDGE 2000. Объём ОЗУ достигает 96 Гбайт. Подсистема хранения данных может объединять три SSD формата М.2 2280 и один модуль М.2 2242: суммарная вместимость — до 26 Тбайт. Упомянуты контроллеры Wi-Fi 6E и Bluetooth 5.3, модем 4G/5G (Dual SIM), четыре порта 2.5GbE и порт 1GbE BMC. У старших моделей есть два разъёма 10GbE SFP+. Диапазон рабочих температур простирается от -40 до +85 °C.

25.05.2024 [20:50], Сергей Карасёв

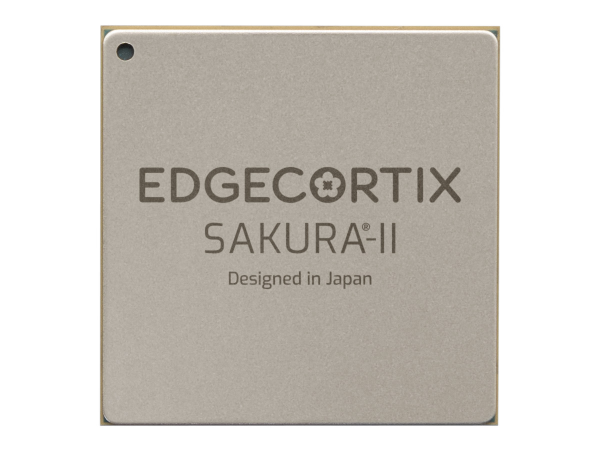

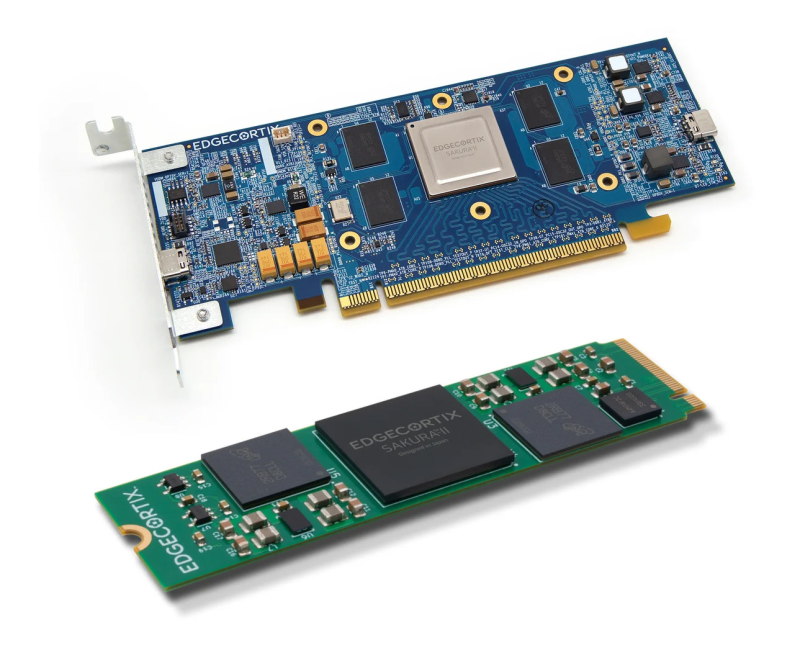

EdgeCortix представила ИИ-ускоритель SAKURA-II Edge AI с производительностью до 60 TOPSКомпания EdgeCortix, по сообщению CNX Software, анонсировала ускоритель SAKURA-II Edge AI, предназначенный для выполнения ИИ-задач на периферии. Новинка, как утверждается, способна справляться с обработкой больших языковых моделей (LLM), больших визуальных моделей (LVM) и пр. В основу изделия положен нейропроцессорный движок с архитектурой Dynamic Neural Accelerator (DNA) второго поколения. Заявленная производительность достигает 60 TOPS на операциях INT8 и 30 Тфлопс на операциях BF16. Ускоритель может нести на борту 8, 16 или 32 Гбайт памяти LPDDR4x с пропускной способностью 68 Гбайт/с. Есть 20 Мбайт памяти SRAM. Заявленное типовое энергопотребление составляет 8 Вт. Изделие имеет упаковку BGA с размерами 19 × 19 мм. Диапазон рабочих температур простирается от -40 до +85 °C. Для ускорителя доступен программный комплект MERA с поддержкой PyTorch, TensorFlow Lite и ONNX. Помимо собственно ускорителя SAKURA-II Edge AI, компания EdgeCortix представила решения на его основе. Это, в частности, модуль формата M.2 2280: он использует интерфейс PCIe Gen 3.0 x4, а энергопотребление равно 10 Вт. Доступны модификации с 8 и 16 Гбайт памяти LPDDR4. Стоят такие модули $249 и $299. Кроме того, выпущены однослотовые низкопрофильные карты расширения с интерфейсом PCIe 3.0 x8. Такие устройства существуют в вариантах с одним и двумя чипами SAKURA-II Edge AI. Во втором случае производительность удваивается и достигает 120 TOPS на операциях INT8 и 60 Тфлопс на операциях BF16. Младшая версия оснащена 16 Гбайт памяти и имеет энергопотребление 10 Вт. Старший вариант несёт на борту 32 Гбайт памяти и обладает энергопотреблением 20 Вт. Цена — $429 и $749 соответственно.

08.05.2024 [12:50], Сергей Карасёв

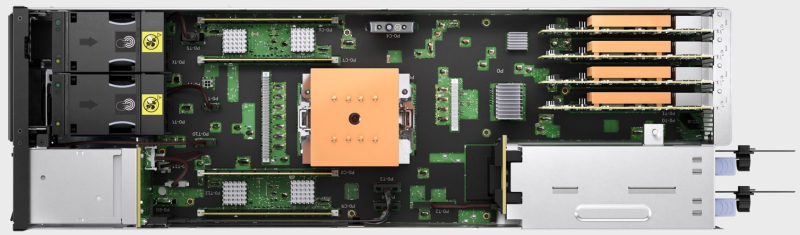

IBM представила небольшой сервер POWER S1012 для ИИ-вычислений на периферииКорпорация IBM анонсировала компактный сервер POWER S1012 на платформе POWER10, предназначенный для решения ИИ-задач на периферии. Новинка будет предлагаться в двух вариантах исполнения — в корпусе башенного типа и в виде системы формата 2U половинной ширины, что позволит размещать в стандартной стойке два устройства бок о бок. Решение оснащается модулем POWER10 eSCM с одним, четырьмя или восемью ядрами (3,0–3,9 ГГц) и 256 Гбайт памяти. Каждое ядро способно выполнять до восьми потоков инструкций одновременно (SMT8), благодаря чему максимальная конфигурация обеспечивает до 64 потоков. Заявленная пропускная способность памяти — до 102 Гбайт/с.

Источник изображений: IBM Конфигурация POWER S1012 (Bonnell) может включать два слота PCIe 5.0 x8 или один слот PCIe 4.0 x16, а также дополнительный разъём PCIe 5.0 x8. Допускается установка четырёх накопителей NVMe U.2. По заявлениям IBM, в плане производительности новинка втрое превосходит сервер POWER S814, поддержка которого закончится буквально на днях. Модификация в формате 2U половинной ширины позволяет сократить пространство для оборудования до 75 % по сравнению со стоечным сервером POWER S1014 (4U). Применение POWER S1012 на периферии даёт возможность выполнять определённые ИИ-задачи непосредственно в точке получения данных, что снижает задержки и уменьшает нагрузку на сетевые каналы. Сервер POWER S1012 станет доступен у IBM и сертифицированных бизнес-партнёров 14 июня 2024 года. Клиенты смогут выбрать оптимальный для себя период поддержки в диапазоне от трёх до пяти лет. Кроме того, в зависимости от потребностей будут доступны дополнительные варианты обслуживания.

30.04.2024 [11:24], Сергей Карасёв

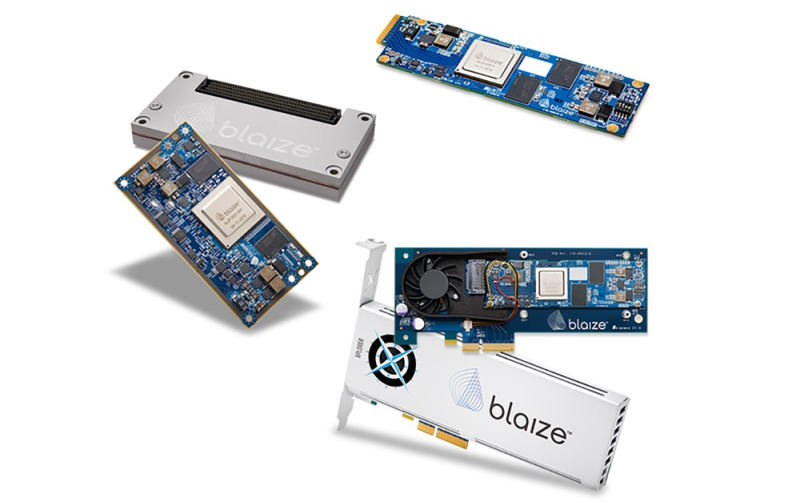

Разработчик ИИ-чипов для ЦОД и периферийных систем Blaize получил на развитие $106 млнСтартап в области ИИ Blaize объявил о проведении раунда финансирования, в ходе которого привлечено $106 млн. Деньги предоставили существующие и новые инвесторы, включая Bess Ventures, Franklin Templeton, DENSO, Mercedes Benz, Temasek, Rizvi Traverse, Ava Investors и BurTech LP LLC. Blaize разрабатывает специализированные чипы, предназначенные для ускорения выполнения ИИ-задач в дата-центрах и на периферии. Утверждается, что по сравнению с традиционными ускорителями на базе GPU и FPGA устройства Blaize обеспечивают более высокую энергетическую эффективность. В основе архитектуры решений Blaize лежит обработка графов, а многие модели ИИ можно как раз представить представить в виде графов. Платформа Blaize включает специализированное ПО Blaize AI Studio и Blaize Picasso SDK, предоставляющее клиентам удобные средства для быстрого создания и развёртывания ИИ-приложений. В ассортименте Blaize присутствуют различные ИИ-устройства на основе чипа Blaize 1600 SoC, содержащего 16 ядер GSP (Graph Streaming Processor). Заявленная ИИ-производительность достигает 16 TOPS. В частности, доступны модуль Blaize Xplorer X600M M.2 (PCIe 3.0 х4; 2 Гбайт LPDDR4), ускоритель Blaize Xplorer X1600E EDSFF (PCIe 3.0 х4; 4 Гбайт LPDDR4), карта расширения Blaize Xplorer X1600P PCIe (PCIe 3.0 х4; 4 Гбайт LPDDR4), ускоритель Xplorer X1600P-Q PCIe на базе четырёх чипов Blaize 1600 SoC (PCIe 3.0 х16; 16 Гбайт LPDDR4), встраиваемое решение Blaize Pathfinder P1600 Embedded System on Module, а также сервер Blaize Inference Server на базе 24 ускорителей Blaize Xplorer X1600E EDSFF. Привлечённые средства Blaize будет использовать для дальнейшей разработки и коммерциализации продуктов. В декабре 2023-го стартап сообщил о намерении выйти на биржу посредством SPAC-сделки с BurTech Acquisition Corp. Ожидается, что это позволит получить $71 млн при оценке компании в $894 млн.

06.04.2024 [21:08], Сергей Карасёв

M.2-модуль Hailo-10 обеспечивает ИИ-производительность до 40 TOPSКомпания Hailo анонсировала специализированный модуль Hailo-10, предназначенный для обслуживания генеративного ИИ. Этот ускоритель с высокой энергетической эффективностью может быть установлен, например, в рабочую станцию или edge-систему. Изделие выполнено в форм-факторе M.2 Key M 2242/2280 с интерфейсом PCIe 3.0 х4. В оснащение входят чип Hailo-10H и 8 Гбайт памяти LPDDR4. Говорится о совместимости с компьютерами, оснащёнными CPU на архитектурах x86 и Aarch64 (Arm64). Заявлена поддержка Windows 11, а также ИИ-фреймворков TensorFlow, TensorFlow Lite, Keras, PyTorch и ONNX. Как отмечает Hailo, новинка обеспечивает ИИ-производительность до 40 TOPS. Типовое энергопотребление составляет менее 3,5 Вт. Утверждается, что ИИ-модуль поддерживает нагрузки, связанные с инференсом, в режиме реального времени. Например, при работе с большой языковой моделью Llama2-7B достигается скорость до 10 токенов в секунду (TPS). При использовании Stable Diffusion 2.1 возможна генерация одного изображения на основе текста менее чем за 5 с. Применение Hailo-10 позволяет перенести определённые ИИ-нагрузки из облака или дата-центра на периферию. Это снижает задержки и даёт возможность решать задачи в офлайновом режиме. Изначально новинка будет позиционироваться для применения в сферах ПК и автомобильных информационно-развлекательных комплексов для обеспечения работы чат-ботов, средств автопилотирования, персональных помощников и систем с голосовым управлением. Поставки образцов Hailo-10 будут организованы во II квартале 2024 года. В ассортименте компании также присутствует ускоритель Hailo-8 в формате M.2: он обеспечивает производительность до 26 TOPS и при этом имеет энергоэффективность 3 TOPS/Вт.

23.03.2024 [22:33], Сергей Карасёв

Akamai внедрит в своей сети ПО Neural Magic для ускорения ИИ-нагрузокCDN-провайдер Akamai Technologies объявил о заключении соглашения о стратегическом партнёрстве с компанией Neural Magic, разработчиком специализированного ПО для ускорения рабочих нагрузок, связанных с ИИ. Сотрудничество призвано расширить возможности глубокого обучения на базе распределённой вычислительной инфраструктуры Akamai. Компания Akamai реализует комплексную стратегию по трансформации в распределённого облачного провайдера. В частности, в начале 2023 года Akamai запустила платформу Connected Cloud на базе Linode: это более распределённая альтернатива сервисам AWS или Azure. А в феврале 2024 года была представлена система Gecko (Generalized Edge Compute), которая позволяет использовать облачные вычисления на периферии.

Источник изображения: pixabay.com В рамках сотрудничества с Neural Magic провайдер предоставит клиентам высокопроизводительную инференс-платформу. Утверждается, что софт Neural Magic даёт возможность запускать ИИ-модели на обычных серверах на базе CPU без дорогостоящих ускорителей на основе GPU. ПО позволяет ускорить выполнение ИИ-задач с помощью технологий автоматического разрежения моделей (model sparsification). Софт Neural Magic дополнит возможности Akamai по масштабированию, обеспечению безопасности и доставке приложений на периферии. Это позволит компаниям развёртывать ИИ-сервисы в инфраструктуре Akamai c более низкими задержками и повышенной производительностью без необходимости аренды GPU-ресурсов. Платформа Akamai и Neural Magic особенно хорошо подходит для ИИ-приложений, в которых большие объёмы входных данных генерируются близко к периферии.

22.03.2024 [23:59], Руслан Авдеев

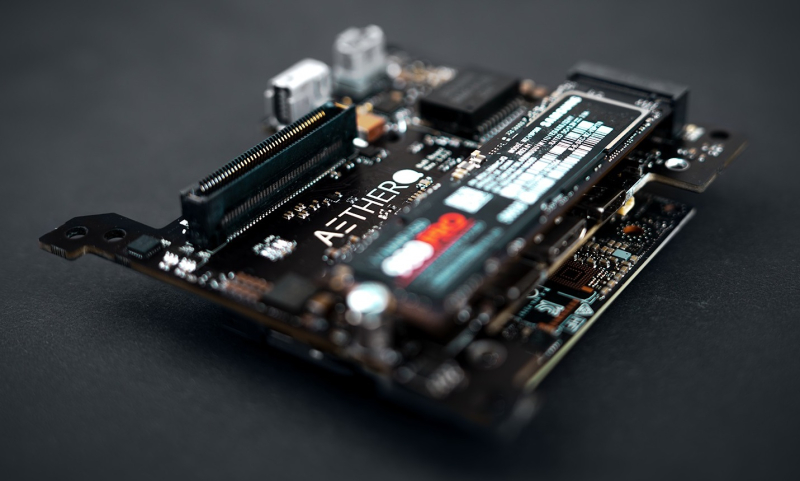

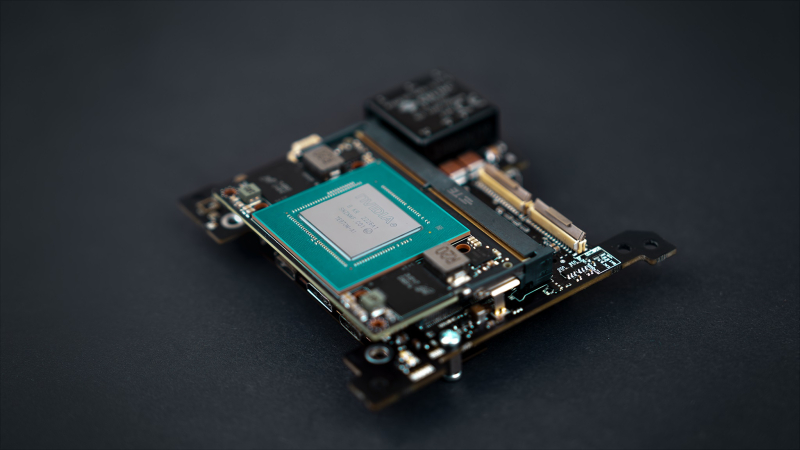

Aethero намерена стать «Intel или NVIDIA в космической индустрии», разработав защищённые ИИ-платформы для спутников и станцийХотя сенсоры многочисленных орбитальных спутников собирают немало информации, у космических аппаратов не хватает вычислительных способностей, чтобы обрабатывать данные на месте. TechCrunch сообщает, что стартап Aethero намерен стать «Intel или NVIDIA в космической индустрии» — компания разрабатывает защищённые от радиации компьютеры для периферийных вычислений на спутниках. Несколько лет назад основатели Aethero создали стартап Stratodyne, занимавшийся строительством стратостатов для дистанционного зондирования (ДЗЗ). Позже компания закрылась, а создатели вернулись к изучению встраиваемых систем для агрессивных сред. Как заявляет Aethero, современные компьютеры для космоса используют устаревшие FPGA и не способны выполнять сложные вычисления вроде тренировки на орбите ИИ-моделей или обслуживания систем компьютерного зрения. Aethero, привлёкшая $1,7 млн, намерена только в этому году трижды отправить свои разработки в космос. Одна из миссий будет выполнена SpaceX уже в июне. Целью является демонстрация работоспособности прототипов вроде возможности обновления набортных моделей компьютерного зрения или тренировки таких моделей непосредственно в космосе на собранных здесь же данных. Космический компьютер первого поколения ECM-NxN использует чип NVIDIA Jetson Orin Nano. В компании утверждают, что сегодня это лучший периферийный ИИ-ускоритель на рынке, а надёжное оборудование собственной разработки позволит сохранить его работоспособность на низкой околоземной орбите в течение 7–10 лет. При этом платформа уместится даже в небольшом аппарате вроде кубсата и обеспечивает производительность в 20 раз выше в сравнении с уже существующими решениями. Впоследствии Aethero намерена выпустить более крупный модуль ECM-NxA на базе NVIDIA AGX, а потом перейти к разработке собственного RISC-V чипа для модуля ECM-0x1. Утверждается, что тот будет потреблять меньше энергии и будет производительнее, чем продукты техногигантов. Выпуск планируется совместно с Intel приблизительно в 2026 году, хотя обстоятельства могут измениться. В Aethero отмечает, что подобные решения могут быть интересны операторам ДЗЗ, орбитальным сервисам и будущим частным космическим станциям. Например, только МКС генерирует терабайты данных ежедневно, напоминает компания. Правда, на МКС работает уже второе поколение космического суперкомпьютера HPE Spaceborne-2, разработчики которого отмечали проблемы с SSD и кешами процессоров из-за радиации. На МКС была протестирована и edge-платформа AWS Snowcone. Более того, ИИ-софт AWS для анализа снимков уже успел поработать на низкоорбитальном спутнике.

13.03.2024 [19:54], Руслан Авдеев

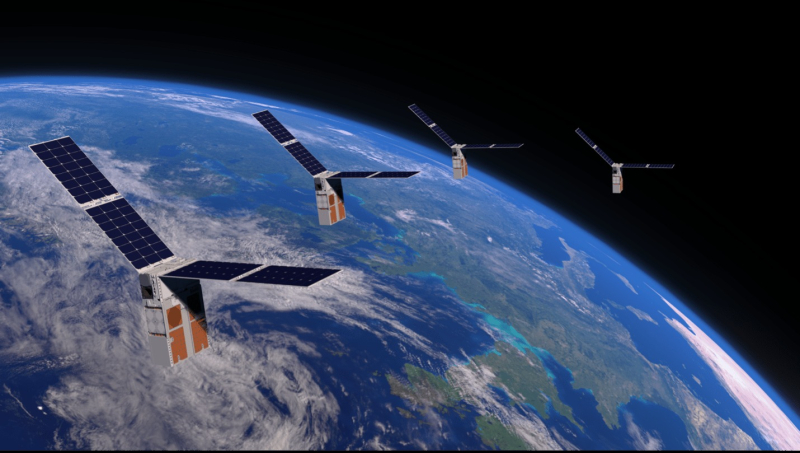

Спутники с GPU: Lumen Orbit намерена развернуть сеть космических микро-ЦОД для ИИ-обработки данныхСтартап Lumen Orbit анонсировал раунд инвестиций, в ходе которого планируется привлечь $2,4 млн на строительство космических дата-центров. По данным Datacenter Dynamics, компания надеется развернуть сотни низкоорбитальных спутников с ускорителями на базе GPU, способных выполнять роль распределённого ЦОД для других космических аппаратов — во многих случаях отпадёт необходимость отправки данных на Землю. По словам главы компании Филипа Джонстона (Philip Johnston), миссия Lumen заключается в запуске группировки орбитальных дата-центров для периферийных вычислений в космосе. Прочие спутники будут отправлять такому космическому ЦОД «сырые» данные на ИИ-обработку, после которой уже готовые результаты будут переправляться на Землю. Это позволит сэкономить пропускную способность космических каналов связи и избежать дорогостоящей переправки массивов данных туда-обратно, да ещё и с высокой задержкой. Компания рассчитывает разместить 300 спутников на высоте около 315 км. Тестовый 60-кг экземпляр намерены отправить уже в мае 2025 года с помощью ракеты SpaceX Falcon 9. Стартап сотрудничает с Ansys и Solidworks, уже подписано несколько меморандумов о взаимопонимании на сумму более $30 млн и даже есть первый потенциальный клиент, который готов опробовать систему в тестовом режиме. Через полгода после теста планируется запустить восемь спутников, а ещё через полгода должны появиться пять орбитальных «колец».

Источник изображения: NASA Lumen стала последней в ряду компаний, желающих разместить вычислительные мощности на орбите. Axiom Space планирует запустить ЦОД на своей космической станции в 2026 году, а NTT и SKY Perfect JSAT уже в 2025 году надеются развернуть спутники для хранения и обработки данных. Крупную вычислительную систему-буксир Blue Ring намерена запустить Blue Origin, но в этом случае речь идёт уже о геосинхронном, а не низкоорбитальном проекте. Концепцию внеземных ЦОД изучают и в Евросоюзе, а ESA сотрудничает с Intel и Ubotica в работе над ИИ-кубсатом PhiSat-1.

01.03.2024 [18:50], Руслан Авдеев

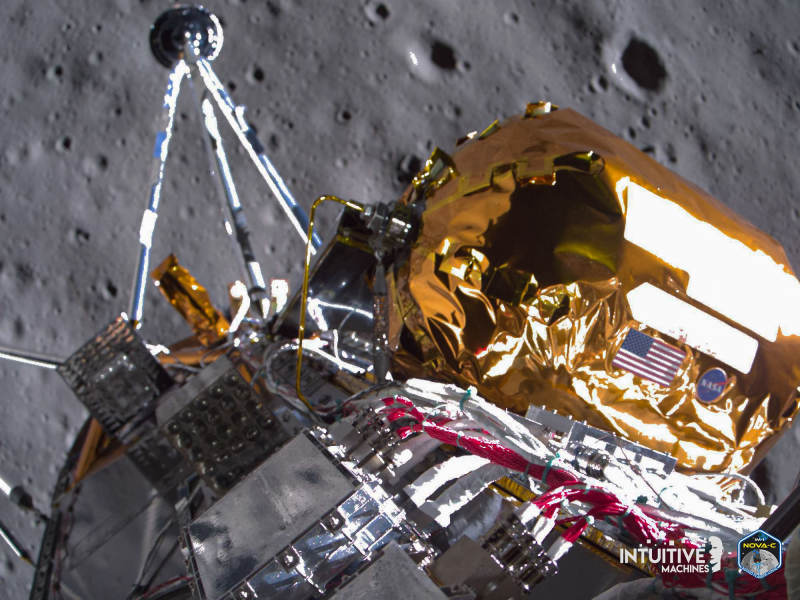

Разработчики космического ЦОД Lonestar Data проверили возможность хранения данных на Луне, но проблемы с «Одиссеем» не дали продолжить экспериментыАмериканская Lonestar Data Holdings провела финальную фазу тестов ЦОД-технологий будущего с помощью лунного посадочного модуля Odysseus («Одиссей»), относительно успешно добравшегося до Луны. Datacenter Dynamics напоминает, что эксперимент провели в рамках миссии IM-1 компании Intuitive Machines. Lonestar передала тексты Декларации независимости и Конституции США с Земли на Луну, а также текст Билля о правах и некоторые данные для штата Флорида. Декларацию отправляли на Odysseus неоднократно — сначала во время полёта к Луне, потом при выходе на окололунную орбиту. Эти тесты были ориентированы на проверку надёжности передачи и хранения данных. Следующая миссия, тоже при участии Intuitive Machines, предусматривает размещение на Луне небольшого ЦОД. Речь идёт о проекте IM-2, который получит специальный SSD-модуль ёмкостью 8 Тбайт и единственную ПЛИС Microchip PolaFire SoC. Этот комплекс станет первым лунным дата-центром Lonestar, хотя и очень простым. Компания намерена проверить, как подобная СХД поведёт себя в экстремальных условиях на поверхности спутника Земли. Впрочем, до реализации IM-2 ещё далеко, особенно с учётом технических проблем, которые привели к не вполне удачному выполнению миссии IM-1, на участие в которой Lonestar привлекла немалые средства. Хотя на первом этапе при посадке проблемы удалось частично решить, позже выяснилось, что посадочный модуль опрокинулся, но смог передать некоторые данные, в том числе связанные с миссией Lonestar. В компании сообщили о «непревзойдённом коммерческом успехе» и даже открытии новой эпохи лунных проектов. |

|